美团发布并开源 LongCat-Flash-Chat 大模型:总参数 560B,AI 智能体任务表现突出

来源:ithome 2025-09-01 11:03:00美团于9月1日正式对外发布了其创新的大型语言模型——LongCat-Flash-Chat,并同步宣布将其开源。在此,特别感谢xiayx网友、Domado以及有鲫雪狐提供的宝贵线索。

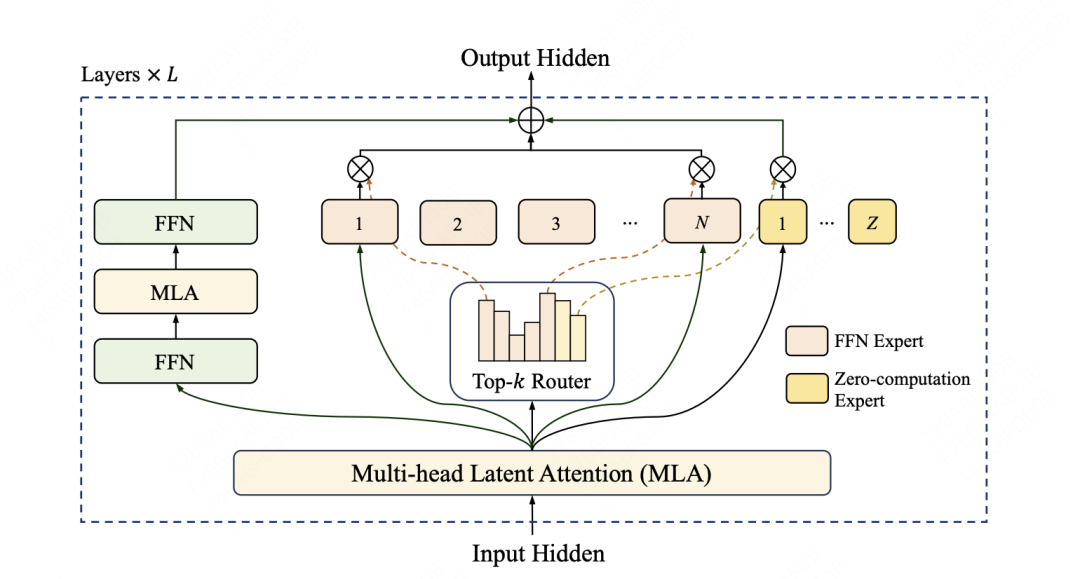

LongCat-Flash模型的核心在于其创新的混合专家模型(MoE,Mixture-of-Experts)架构。这款模型拥有高达5600亿的总参数量,但在实际运行中,每个任务仅激活186亿至313亿参数(平均约为270亿)。这种独特的设计,旨在实现计算效率与卓越性能的双重提升。

在架构设计上,LongCat-Flash模型巧妙地引入了“零计算专家”机制。尽管其总参数量高达5600亿,但每个token在处理时,会根据具体的上下文需求,智能地激活约186亿至313亿参数。这种按需分配算力的方式,极大地提升了资源的利用效率。为了精确控制整体算力消耗,模型在训练过程中还运用了PID控制器,实时微调专家偏置,从而将单个token的平均激活量稳定在约270亿。

▲ LongCat-Flash 架构图

▲ LongCat-Flash 架构图

更值得一提的是,LongCat-Flash在模型层间构建了跨层通道,这使得MoE架构的通信与计算能够实现高度并行,从而显著提升了训练和推理的效率。得益于一系列定制化的底层优化,LongCat-Flash仅用了30天就完成了训练,并且在H800硬件平台上,能够为单个用户提供高达每秒100个token的推理速度。此外,团队还对常见的大模型组件和训练方法进行了创新性改进,例如采用超参迁移和模型层叠加等技术,并结合多项策略,确保了整个训练过程的稳定可靠。

在智能体(Agentic)能力方面,LongCat-Flash也下足了功夫。它不仅构建了专属的Agentic评测集来指导数据策略,更在整个训练流程中进行了全面优化。例如,通过运用多智能体方法生成多样化且高质量的轨迹数据,LongCat-Flash成功实现了更卓越的智能体功能。

得益于算法与工程层面的紧密结合与联合设计,LongCat-Flash在理论上展现出远超行业同等规模乃至更小模型的成本效益与处理速度。通过一系列精密的系统优化,LongCat-Flash在H800硬件上实现了惊人的每秒100个token的生成速度,同时将输出成本大幅降低至每百万token仅需5元,真正做到了极致性能与经济效益的完美平衡。

综合多项基准测试的评估结果显示,LongCat-Flash-Chat作为一款非思考型基础模型,即便在仅激活少量参数的情况下,其性能依然能够与当前领先的主流模型相媲美,尤其在智能体任务中表现出显著的优势。值得一提的是,由于其在设计之初就高度重视推理效率和创新,LongCat-Flash-Chat拥有明显更快的推理速度,这使得它特别适合应用于那些耗时较长的复杂智能体场景。

具体来看,在通用领域知识方面,LongCat-Flash的表现同样亮眼。它在ArenaHard-V2基准测试中获得了86.50的高分,位列所有参评模型的第二名。而在基础基准测试中,其MMLU(多任务语言理解基准)得分达到89.71,CEval(中文通用能力评估基准)更是高达90.44。这些卓越的成绩足以与目前国内的领先模型一较高

侠游戏发布此文仅为了传递信息,不代表侠游戏网站认同其观点或证实其描述

相关攻略

更多同类更新

更多热游推荐

更多-

- 战地模拟器 Steam

- Android/ | 模拟养成

- 2025-10-12

-

-

-

- 八门神器 无实名认证

- Android/ | 手游辅助

- 2025-10-12

-

-

-

-